[樂游網(wǎng)導(dǎo)讀]Stable Diffusion是一個(gè)人工智能圖像生成工具,屬于非常強(qiáng)大的生成式ai,可以通過文生圖或者是圖生圖的方式進(jìn)行自由的繪畫創(chuàng)作,而且效果比普通的畫師要好很多,如果你的電腦配置稍微好一點(diǎn)的話,可以做到1分鐘出圖,當(dāng)然前提是需要訓(xùn)練好模型,接下來小編會(huì)為大家介紹小白的使用教程,感興趣的親們趕緊來看看吧。

Stable Diffusion是一個(gè)人工智能圖像生成工具,屬于非常強(qiáng)大的生成式ai,可以通過文生圖或者是圖生圖的方式進(jìn)行自由的繪畫創(chuàng)作,而且效果比普通的畫師要好很多,如果你的電腦配置稍微好一點(diǎn)的話,可以做到1分鐘出圖,當(dāng)然前提是需要訓(xùn)練好模型,接下來小編會(huì)為大家介紹小白的使用教程,感興趣的親們趕緊來看看吧。

stable diffusion2.0手機(jī)版app:點(diǎn)擊下載

Stable Diffusion怎么使用

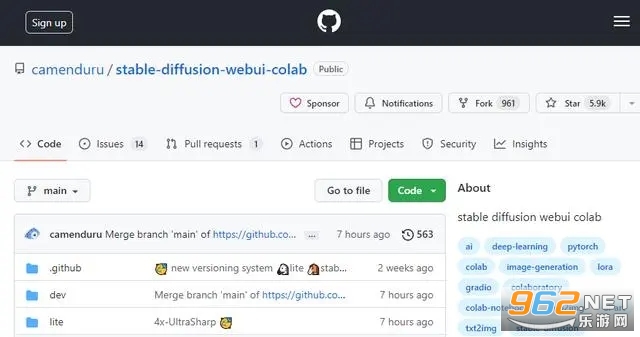

首先打開

https://github.com/camenduru/stable-diffusion-webui-colab網(wǎng)站

這是運(yùn)行在谷歌colab的,沒有顯卡也可以生成圖片,非常的奈斯

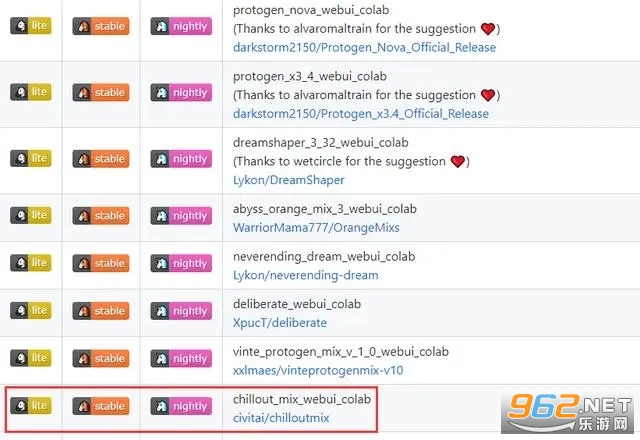

下拉選擇一個(gè)模型

選擇chilloutmix這個(gè)模型點(diǎn)擊stable運(yùn)行它,其他的模型都可以試試

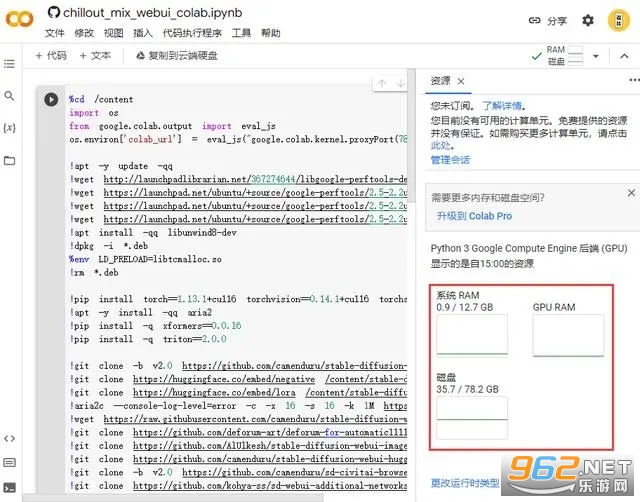

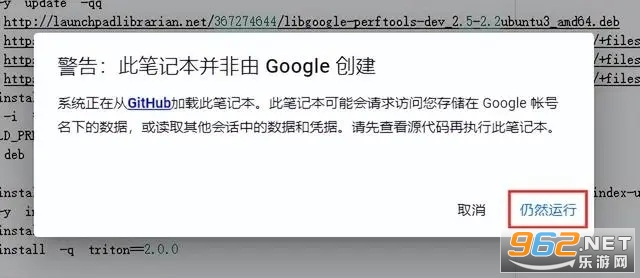

點(diǎn)擊連接等待一會(huì)

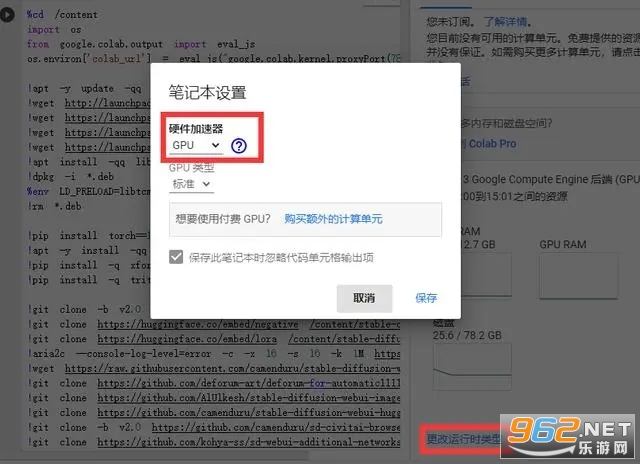

連接成功了里面要有GPU的,沒有的話點(diǎn)擊更改運(yùn)行時(shí)類型,選擇GPU保存

然后點(diǎn)擊這個(gè)按鈕,開始運(yùn)行

然后點(diǎn)擊這個(gè)按鈕,開始運(yùn)行

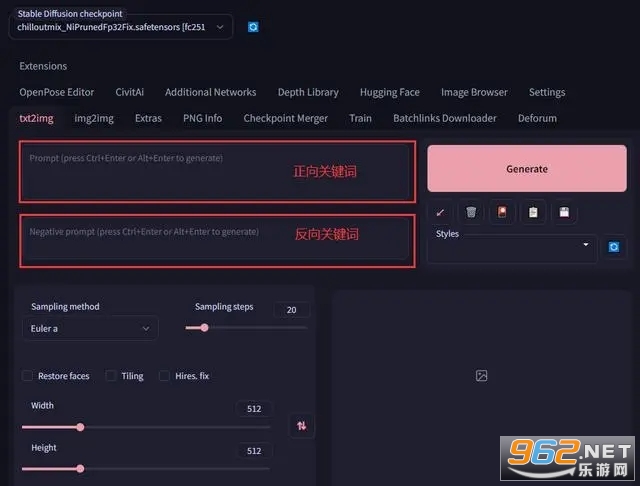

看到出現(xiàn)鏈接地址就OK了,點(diǎn)擊下面的鏈接進(jìn)入

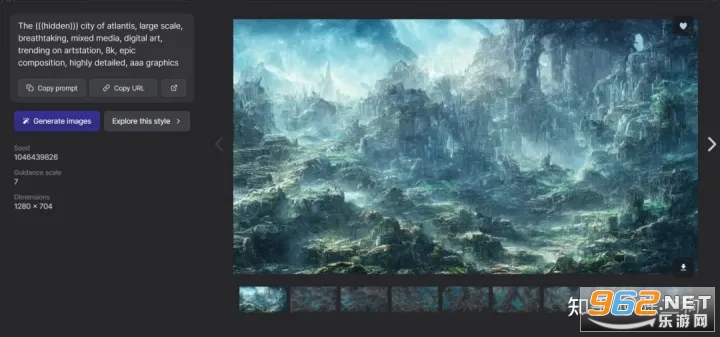

進(jìn)來的界面就是這樣子的,里面兩個(gè)框框是輸入關(guān)鍵詞的,正向關(guān)鍵詞就是需要AI算出來的畫面包含的元素,反向關(guān)鍵詞就是不希望出現(xiàn)的怪東西(你懂得),填入好信息后點(diǎn)擊Generate等待一會(huì)圖片就生成出來了。

StableDiffusion怎么喂圖

1.文生圖

在開始使用文生圖之前,有必要了解以下幾個(gè)參數(shù)的含義:

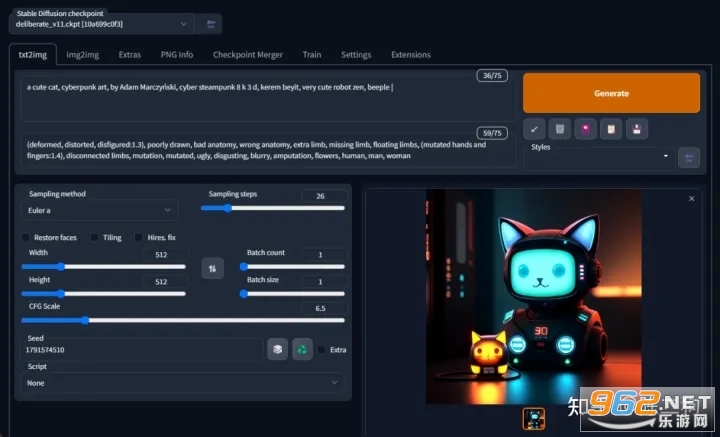

接下來我們來生成一張賽博朋克風(fēng)格的貓咪圖片,配置以下參數(shù)后,點(diǎn)擊 "Generate" 即可:

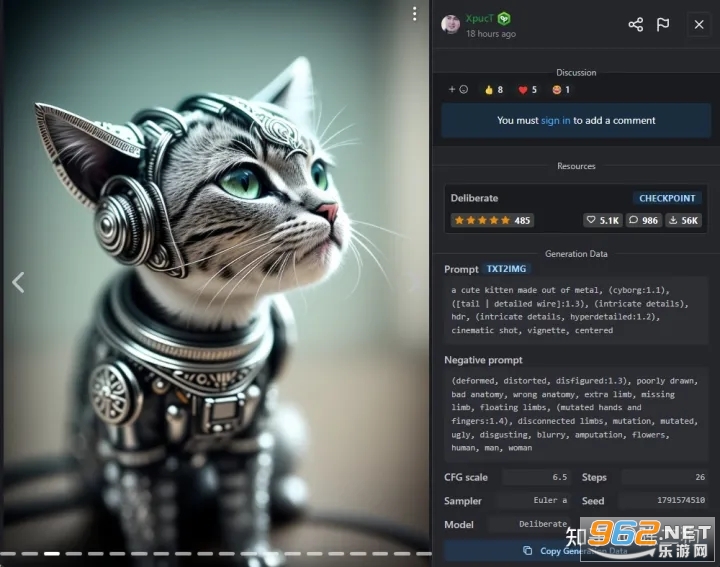

Prompt:a cute cat, cyberpunk art, by Adam Marczyński, cyber steampunk 8 k 3 d, kerem beyit, very cute robot zen, beeple |Negative prompt:(deformed, distorted, disfigured:1.3), poorly drawn, bad anatomy, wrong anatomy, extra limb, missing limb, floating limbs, (mutated hands and fingers:1.4), disconnected limbs, mutation, mutated, ugly, disgusting, blurry, amputation, flowers, human, man, womanCFG scale:6.5Sampling method:Euler aSampling steps:26Seed:1791574510

注:提示詞(Prompt)越多,AI 繪圖結(jié)果會(huì)更加精準(zhǔn),另外,目前中文提示詞的效果不好,還得使用英文提示詞。

下載安裝后輸入自定義prompt,也就是任意你想生成的圖像內(nèi)容,然后點(diǎn)擊生成就好了。如果不滿意,可以再次點(diǎn)擊,每次將隨機(jī)生成不同的圖片,總有一些你感興趣的。

3.圖生圖

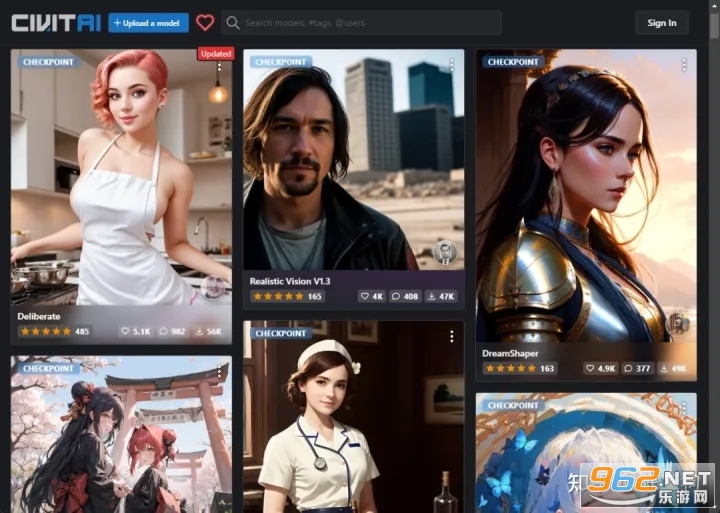

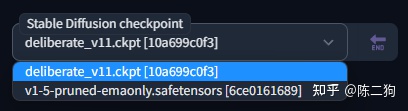

眼尖的你可能發(fā)現(xiàn)了,上面截圖里左上角 Stable Diffusion checkpoint 的值怎么跟之前截圖里的不一樣?這是因?yàn)槲覔Q了一個(gè)模型文件,還記得前面提到那個(gè)將近 4 個(gè) G 大小的模型文件(v1-5-pruned-emaonly.safetensors)嗎?那是 stable-diffusion-webui 的默認(rèn)模型文件,用這個(gè)模型文件生成出來的圖片比較丑,因此我換了另一個(gè)模型文件。模型文件下載的網(wǎng)站幾個(gè),比較出名的就是 civitai,這上面共享的都是別人訓(xùn)練好的模型。

模型文件下載地址:

civitai:https://civitai.com/

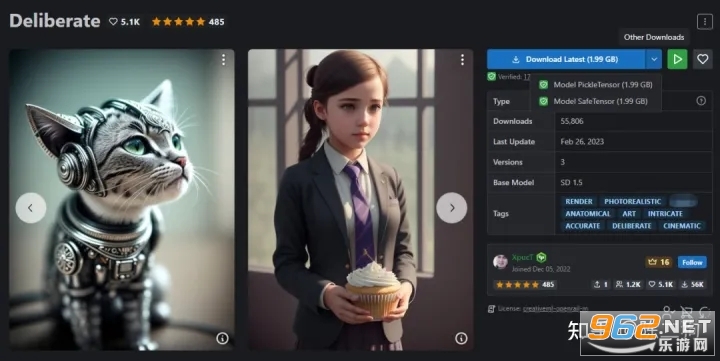

根據(jù)你要生成的圖片風(fēng)格(比如:動(dòng)漫、風(fēng)景),挑選合適的模型查看,前面那個(gè)文生圖的例子,使用的就是這個(gè) Deliberate 模型,直接點(diǎn)擊 "Download Latest" 即可下載該模型文件。

注:模型文件有 2 種格式,分別是 .ckpt(Model PickleTensor) 和 .safetensors(Model SafeTensor),據(jù)說 .safetensors 更安全,這兩種格式 stable-diffusion-webui 都支持,隨意下載一種即可。

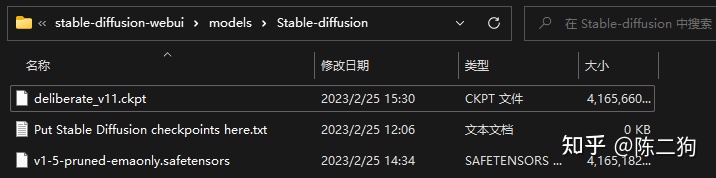

將下載好的模型文件放到 stable-diffusion-webui\models\Stable-diffusion 目錄下:

放置好模型文件之后,需要重啟一下 stable-diffusion-webui(執(zhí)行 webui-user.bat)才能識(shí)別到。

這些模型文件一般會(huì)附帶一組效果圖,點(diǎn)擊任意一張,就可以看到生成該效果圖的一些參數(shù)配置:

把這些參數(shù)配置到 stable-diffusion-webui 中,點(diǎn)擊 "Generate" 就可以生成類似效果的圖片了。

注:因?yàn)?AI 繪圖帶有隨機(jī)性質(zhì),所以生成出來的圖片跟效果圖不一定完全一樣。

文生圖功能有很多東西可以發(fā)掘,你可以用它來生成世界上獨(dú)一無二的圖片,而要用好文生圖功能,提示詞(Prompt)是必須掌握的重中之重,它是有語(yǔ)法規(guī)則的,具體接著往下看。

3.TAG生成器

https://tag.muhou.net

關(guān)于如何構(gòu)思prompt提示語(yǔ),可以從如下幾個(gè)問題入手:

你想要一張照片,還是一幅畫(photo/painting)

你想要什么內(nèi)容,比如:人物,動(dòng)物,還是風(fēng)景(person/animal/landscape)

需要什么樣的細(xì)節(jié),比如:

環(huán)境,室內(nèi)/室外/水下/太空(indoor/outdoor/underwater/in space)

視角,正面/側(cè)面/俯視(front/side/overhead)

背景,純色/星系/森林(solid color/nebula/forest)

打光,柔光/環(huán)境光/環(huán)形光/霓虹(soft/ambient/ring light/neon)

顏色調(diào)性,鮮活/暗黑/柔和(vibrant/dark/pastel)

需要怎樣的藝術(shù)風(fēng)格,比如:3D渲染/電影海報(bào)/畢加索(3D render/movie poster/Picasso)

觀察者鏡頭選擇,比如:微距/長(zhǎng)焦(macro/telephoto)

如何組織語(yǔ)言:

把想畫的內(nèi)容和形式用只言片語(yǔ)一條一條列出來,而不是企圖用一條完整通順的話來描述

只言片語(yǔ)的順序很重要,越想強(qiáng)調(diào)的越放到前面

提示語(yǔ)涉及哪些修飾形容角度:

藝術(shù)(表現(xiàn)形式/媒體形式)

藝術(shù)家(人像/景觀/恐怖/二次元/科幻/游戲概念)

插畫(3D/各類風(fēng)格/角色設(shè)計(jì))

情緒(各種正面的/各種負(fù)面的)

審美特點(diǎn)(活力感/暗黑系/歷史感)

以上各角度可以混合使用

提示語(yǔ)還涉及哪些特殊詞組:

HDR, UHD, 64K

highly detailed

studio lighting

professional

trending on artstation

unreal engine

vivid colors

bokeh

high resolution scan

sketch/painting

stable diffusion 重點(diǎn)參數(shù)解析:

CFG(classifier free guidance),數(shù)字越大越貼近提示語(yǔ)的描述

step count,合適為佳,并非越大越好,需要測(cè)試

seed,初始隨機(jī)噪聲值,設(shè)定同一seed,可以復(fù)原已出圖片;注意某些seed值與特定提示語(yǔ)配合很好,更容易出效果

如何優(yōu)化提示語(yǔ)權(quán)重

使用 ( ) 增強(qiáng)模型對(duì)特定詞語(yǔ)的關(guān)注,使用 [ ] 減弱其關(guān)注

多以使用多個(gè) () 或 [],比如:((( )))、[[ ]] 等

也可以使用 (word:1.5)、(word:0.25) 的方式增強(qiáng)或減弱某個(gè)詞語(yǔ)的權(quán)重

如何混合兩個(gè)提示詞

提示編輯允許您開始對(duì)一張圖片進(jìn)行采樣,但在中間切換到其他圖片。其基本語(yǔ)法為 [from:to:when]

比如:a [fantasy:cyberpunk:16] landscape,16步之前是 a fantasy landscape,16步之后是 a cyberpunk landscape

比如:a [mountain:lake:0.25],假定sampler有100步,則前25步是 a mountain,后75步是 a lake

補(bǔ)充信息

提示語(yǔ)長(zhǎng)度,舊版的 stable diffusion 有效token長(zhǎng)度只有75,簡(jiǎn)單理解,只能支持70個(gè)左右的單詞數(shù)量,新版的移除了token長(zhǎng)度限制,但總體而言,不宜用特別長(zhǎng)的提示語(yǔ)

喜歡

喜歡  頂

頂 無聊

無聊 圍觀

圍觀 囧

囧 難過

難過 Stable Diffusion Ai app安裝 v1.0

安卓實(shí)用工具 / 23-03-31

Stable Diffusion Ai app安裝 v1.0

安卓實(shí)用工具 / 23-03-31

stable diffusion2.0手機(jī)版app最新版 v1.14

安卓實(shí)用工具 / 23-04-16

stable diffusion2.0手機(jī)版app最新版 v1.14

安卓實(shí)用工具 / 23-04-16

Stable Diffusion2.0(AI painter)v1.14 手機(jī)版

安卓實(shí)用工具 / 23-03-08

Stable Diffusion2.0(AI painter)v1.14 手機(jī)版

安卓實(shí)用工具 / 23-03-08

索尼imaging edge Mobile官方版v7.7.2最新版

安卓攝影攝像 / 23-04-06

索尼imaging edge Mobile官方版v7.7.2最新版

安卓攝影攝像 / 23-04-06

imaging edge(索尼微單相機(jī)手機(jī)版)app最新版 v7.7.2

安卓實(shí)用工具 / 23-04-06

imaging edge(索尼微單相機(jī)手機(jī)版)app最新版 v7.7.2

安卓實(shí)用工具 / 23-04-06

imaging edge(索尼微單手機(jī)傳輸照片app)安卓 v7.7.2

安卓攝影攝像 / 23-04-06

imaging edge(索尼微單手機(jī)傳輸照片app)安卓 v7.7.2

安卓攝影攝像 / 23-04-06

專業(yè)的游戲下載、綜合門戶網(wǎng)站

Copyright 2009-2016 m.mmd178.cn 版權(quán)所有

鄂ICP備17018784號(hào)-1

熱門評(píng)論

最新評(píng)論